Générer ou supprimer du contenu dans une photo, en modifier ou en étendre l’arrière-plan ? Rien de bien nouveau dans le monde de l’image. Le faire en un seul clic ? La révolution du remplissage génératif est en marche !

Le livre « 58 leçons pour réussir vos photos » par Jacques Croizer

Cet article a été rédigé par Jacques Croizer. Collaborateur régulier de Nikon Passion, Jacques a écrit un guide photo à destination des débutants et amateurs et que je vous recommande vraiment.

Qu’est-ce que le remplissage génératif ?

Le remplissage génératif est une technique utilisée en intelligence artificielle pour produire automatiquement des informations dans un ensemble de données. Elles peuvent venir remplacer des valeurs manquantes, corriger des données aberrantes ou élargir un ensemble existant, tout en garantissant sa cohérence globale.

En utilisant le remplissage génératif dans le domaine de la photographie, il devient possible de modifier une partie de l’image, par exemple pour en supprimer un détail indésirable, ou d’en étendre le cadre en concrétisant un hors champ réaliste basé sur le contenu initial de la prise de vue.

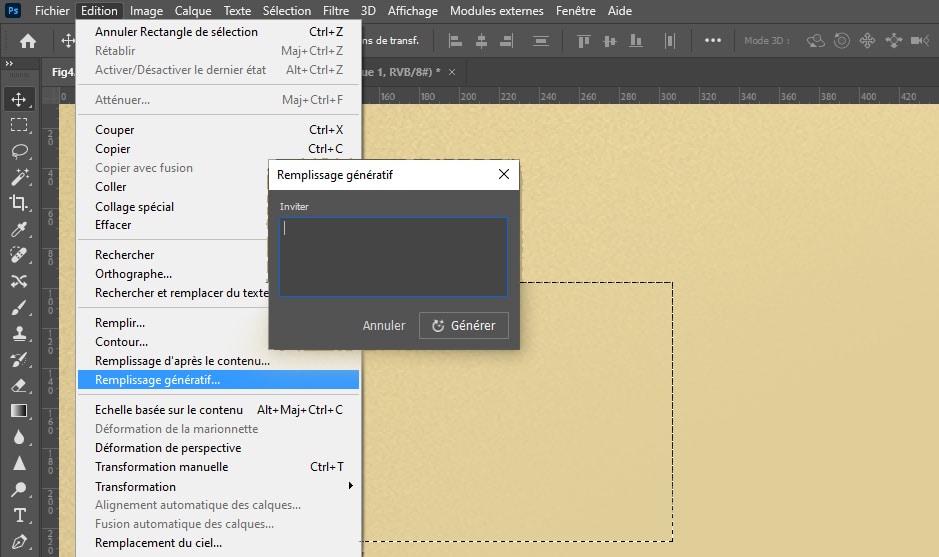

Le menu « remplissage génératif de Photoshop CC

Les outils traditionnels de remplissage, déjà présents depuis longtemps dans les logiciels de post-traitement, sont bien connus des retoucheurs expérimentés. Une fois une zone de l’image sélectionnée, il leur suffit de choisir un mode de remplissage pour en modifier le contenu, tout en prenant en compte son contexte initial.

Le terme « génératif » introduit une nouvelle dimension : la possibilité d’indiquer par un « prompt » comment doit se faire le remplissage. Le prompt est une consigne rédigée en langage naturel.

A moins d’habiter sur une autre planète, vous n’avez pas pu passer à côté de cette technique utilisée dans les applications telles DALL-E, Midjourney ou Firefly pour ne citer que ces trois alternatives. Elle a également été introduite dans la version bêta de Photoshop CC publiée fin mai 2023 par Adobe.

Pour obtenir l’image ci-dessous, il a suffi d’indiquer (en anglais pour l’instant…) : « Une tasse de café fumante avec une cuillère sur un fond blanc ».

Image générée par une intelligence artificielle (Adobe Firefly)

Les photographes spécialisés dans l’illustration apprécieront… Le web s’est instantanément enflammé, multipliant les exemples plus ou moins convaincants, s’enthousiasmant tout en s’inquiétant et pointant du doigt les inévitables manquements d’une technologie encore balbutiante.

N’oublions pas en effet qu’une version bêta est essentiellement une version de test du logiciel. Elle n’a pas de vocation commerciale. Son objectif principal est de recueillir les avis des utilisateurs afin de s’améliorer avant diffusion officielle.

Dans cette optique, les propositions faites par l’intelligence artificielle peuvent être notées et commentées. Ces retours sont ensuite utilisés par les algorithmes d’apprentissage profond (deep learning) pour continuer de progresser dans une boucle vertueuse bénéfique à tous.

L’intelligence artificielle : bref rappel historique

Les prémisses de l’intelligence artificielle remontent à la fin des années 50. Il a pourtant fallu attendre la dernière décennie pour que la possibilité de générer une image réaliste à l’aide d’un ordinateur devienne crédible.

En 2016, Microsoft présente le projet « Next Rembrandt« . Il attend de l’IA qu’elle peigne une nouvelle toile à la manière si caractéristique de l’artiste néerlandais. L’œuvre sera ensuite imprimée en plusieurs couches par une imprimante 3D. En 2018 le collectif Obvious, réalise une galerie de portraits de la famille imaginaire Bellamy.

Ces deux initiatives font connaitre au grand public l’incroyable potentiel de l’intelligence artificielle appliquée à la création d’images. Elles ont cependant en commun de travailler sur un corpus d’apprentissage réduit à la seule œuvre du peintre pour la première, à une collection de portraits classiques, réalisés entre le XIVème et le XIXème siècle, pour la seconde. Elles utilisent de plus un prompt (ou une consigne) unique et non paramétrable : « dessiner un portrait à partir de … »

Le nouveau Rembrandt (C) ING Group

Combien de temps faudra-t-il encore attendre avant que ces techniques soient généralisées ? Au début de l’année 2021, je publiais ici deux articles sur l’utilisation de l’intelligence artificielle en photographie. Le premier offrait un aperçu rapide du logiciel Facet, un outil de retouche plutôt original. Le second article, plus général, faisait le point sur l’utilisation de l’intelligence artificielle dans le cadre de la retouche photographique.

J’ai été été bien inspiré à l’époque de ne faire aucune prédiction à court ou moyen terme ! J’étais loin d’imaginer que, seulement deux ans après la rédaction de ces premiers articles, il serait si facile de générer à partir de rien des images crédibles (même si elles sont encore souvent imparfaites) à l’aide d’applications déconcertantes de simplicité.

Les principes du remplissage génératif

Les modèles de remplissage génératif utilisent des réseaux de neurones récurrents (RNN) entraînés sur de grandes quantités de texte et d’images. Cette opération exige des ressources de calcul considérables. Elles demeurent partiellement nécessaires, tant pour comprendre le prompt rédigé en langage naturel que pour le traduire en image. C’est pourquoi ces tâches sont généralement déportées vers le cloud et requièrent une connexion Internet.

Une première « graine » initialise le travail de l’algorithme de remplissage. Elle peut être une petite partie de l’image existante, ou un motif spécifique. Rassurez-vous, c’est l’algorithme qui la choisit. Il extrapole ce point de départ et remplit la zone sélectionnée de manière plausible.

Chaque nouvelle génération utilise une graine distincte et aboutit donc à une image différente. Le travail de l’opérateur se résume à choisir la version qui correspond le mieux à ses attentes. Créativité ? Vous avez dit créativité ?

Différents modes d’utilisation du remplissage génératif

Le remplissage génératif implémenté dans Photoshop CC remplit principalement trois fonctions que nous allons maintenant survoler.

Supprimer un élément de l’image

Pour supprimer l’homme au parapluie sur l’image ci-dessous, il a suffi de le sélectionner grossièrement avec le lasso, de laisser le prompt vide et de cliquer sur générer. La transformation prend quelques secondes.

Trois solutions sont proposées dans un groupe de calques. Toutes reconstituent proprement la ligne d’horizon et le ponton. Simple et efficace. Un masque de fusion est automatiquement associé au calque courant. Il permet si nécessaire d’optimiser l’intégration de la zone modifiée.

Suppression d’un élément dans Photoshop – photo (C) J. Croizer

Le résultat n’en est pas pour autant assuré à coup sûr. Sur la photo suivante, j’ai cherché à éliminer l’homme au masque. Le tracé est affiné autour du personnage afin de minimiser la surface à remplir. L’intention est vertueuse mais mal interprétée : le remplissage génératif s’obstine à remplacer la sélection par une autre silhouette, sortie de nulle part !

Echec de la suppression d’un élément dans Photoshop – photo (C) J. Croizer

En revanche, si je sélectionne un large rectangle autour du personnage à supprimer, le remplissage génératif reconstitue à sa place un pan de porte vide dont le vitrage affiche des ombres et reflets parfaitement convaincants.

Suppression réussie d’un élément dans Photoshop – photo (C) J. Croizer

Le remplissage génératif apparait donc comme un coup de poker, un quitte ou double dans lequel l’intelligence artificielle possède tous les atouts. Il ne faut pas hésiter à multiplier les essais pour arriver au résultat souhaité.

Agrandir l’image

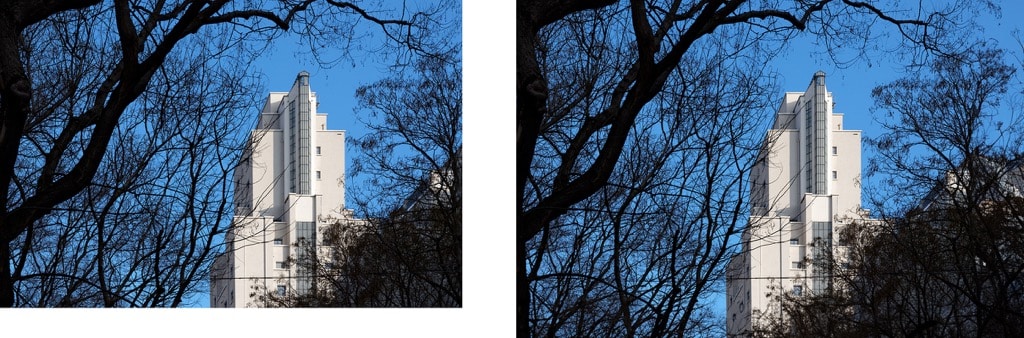

Le cadrage de la photo ci-dessous parait un peu serré en bas et à droite. Ce n’est plus un problème : Adobe Firefly peut recréer le contenu manquant, ou plus exactement, un contenu virtuel compatible avec le contexte déjà existant.

La fonction « Taille de la zone de travail » de Photoshop permet dans un premier temps d’ajouter une marge blanche sur les deux côtés concernés de l’image.

Il suffit ensuite de la sélectionner en mordant légèrement sur l’image source et de lancer le remplissage génératif, sans indiquer de prompt. Trois propositions sont automatiquement générées. Il reste à choisir celle qui convient le mieux.

Agrandissement génératif d’une image dans Photoshop – photo (C) J. Croizer

Simple et rapide… mais à vrai dire, il aurait été encore plus efficace d’y penser dès la prise de vue !

Remplacer un élément dans l’image

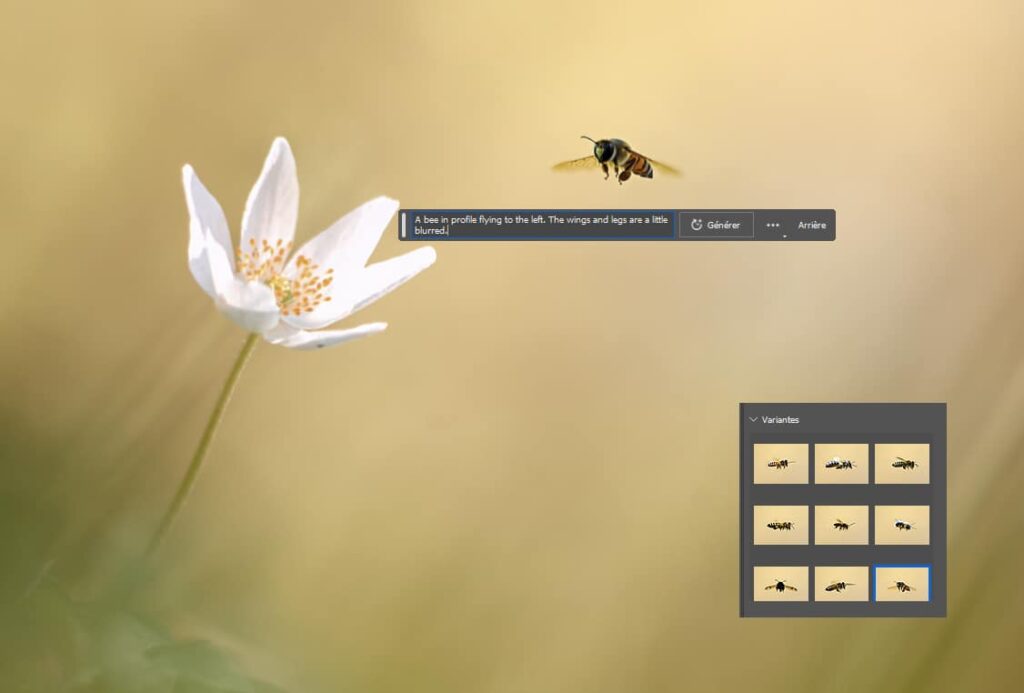

Les deux précédentes opérations existaient déjà dans Photoshop avec les fonctions « Remplir » et « Remplissage d’après le contenu » du menu « Edition ». Sans doute étaient-elles moins efficientes. La véritable innovation est cependant à rechercher dans la troisième option : elle permet de remplacer un élément de l’image par un autre élément dont on donne la description.

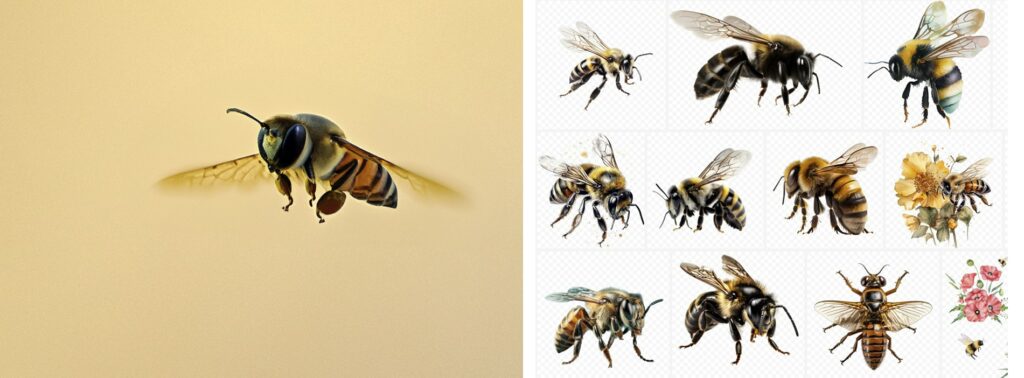

Prenons un exemple simple. L’abeille de la photo ci-dessous n’existait pas dans l’image initiale. Il m’a suffi de définir son emplacement avec le lasso puis de cliquer sur « générer » après avoir renseigné le prompt : une abeille de profil volant vers la gauche. Les ailes et les pattes sont un peu floues. La taille de la sélection donne celle de l’insecte.

Ajout d’un élément dans une image avec Photoshop – photo (C) J. Croizer

A l’échelle du Web, le résultat peut paraitre stupéfiant. La magie opère, mais elle est encore imparfaite. La consigne n’est en effet que partiellement comprise. Par exemple, sur les neuf vignettes successivement générées, seules deux respectent l’indication de direction du mouvement.

Ce manquement n’est pas une surprise. Adobe Firefly exploite les images de la banque d’images Adobe Stock et les labels qui leur sont associés. L’application se distingue d’ailleurs en cela de ses concurrentes dont le corpus d’apprentissage n’est pas sourcé, La collecte massive d’informations sur le Web (web scraping) pose alors la question du droit d’auteur… Quoiqu’il en soit, le sens de déplacement est rarement précisé dans le descriptif des images. L’algorithme ne peut donc pas l’intégrer.

Comparaison de l’image générée avec celles enregistrées dans Adobe Stock

Un petit tour sur Adobe Stock permet de constater que l’image source de l’abeille n’est pas un simple copier/coller d’une image existante, mais bel et bien une pure création de l’IA. Avions-nous vraiment besoin de faire cette vérification ultime pour s’en convaincre ? L’implantation et le nombre des pattes de l’insecte sont plus que discutables. Il lui manque par ailleurs une antenne…

La page blanche

L’opération ultime consiste à démarrer d’une page blanche pour créer une image complète à partir d’un prompt. Celle du pape en doudoune ou celle d’Emmanuel Macron participant à la collecte des déchets dans les rues de Paris (générées par Midjourney) ont suffisamment circulé sur la toile pour que je vous en épargne une nouvelle description. L’illustration en tête de cet article et celles de la tasse de café relèvent du même processus.

Tentons à nouveau de générer une image à partir du prompt suivant : photo en noir et blanc d’un artisan qui travaille dans son atelier mal éclairé. La consigne est volontairement imprécise pour s’éviter les problèmes rencontrés avec l’abeille. Le résultat est, en première approche, plutôt réaliste. Il ne résiste toutefois pas à un examen plus approfondi. Problème récurrent des images générées par l’IA, les mains semblent plus appartenir à un alien qu’à un humain. La montre aurait par ailleurs beaucoup de mal à donner l’heure…

Cet homme n’existe pas !

Les progrès réalisés depuis la génération, il y a seulement cinq ans, du portrait d’Edmond de Belamy sont néanmoins époustouflants. La suite s’annonce passionnante, mais il reste encore beaucoup de barrières à lever.

Dans les premiers articles, j’avais déjà mis en évidence les difficultés liées à la détermination des frontières de chaque sujet dans les zones floues. De manière plus générale, il reste encore des aspects à améliorer en ce qui concerne la vraisemblance des différents éléments ajoutés dans l’image, l’homogénéité de leur définition (piqué/netteté), la cohérence globale de la profondeur de champ et de la perspective…

Retour à la photographie

Effacer des éléments dans une image, en rajouter à l’aide de calques, ces pratiques de post traitement feront toujours débat. Il convient simplement de bien différencier ce qui est du domaine artistique de ce qui relève de l’information. Mais lorsque l’on utilise le remplissage génératif à partir de quelques mots pour modifier tout ou partie d’une image, fait-on encore de la photographie ?

Revenons aux sources, quitte à ressortir un marronnier des écrits sur l’histoire de la photographie. Etymologiquement, le mot « photographie » est dérivé de deux termes grecs qui signifient « lumière » et « écriture ». Le processus à la base de nos images consiste en effet à figer une représentation du réel à l’aide de la lumière.

Le remplissage génératif se base sur un ensemble d’images déjà enregistrées, sur lequel un modèle d’apprentissage automatique a été entrainé afin de construire une nouvelle image totalement fictive. S’il s’agit bien d’écriture, la « graphie » est cette fois ci générée par un algorithme et non par la lumière. On ne devrait donc pas parler de photographie, mais plutôt d’algographie.

Une fois cela dit, reconnaissons que l’intelligence artificielle permet aussi de retravailler rapidement une image de manière réaliste, ce qui nous ramène au point de départ. Création ou information ? Utilisée en tant que technique créative, il apparait légitime d’élargir le champ photographique afin d’accueillir ces nouveaux outils. La simple honnêteté intellectuelle exige alors simplement de le préciser en publiant l’image.

Il est louable que l’application Adobe Firefly laisse son empreinte dans un coin de la photo. Cette marque peut cependant être facilement supprimée à l’aide de Photoshop. Comme bien souvent, le ver est dans le fruit…

Image générée par l’application Adobe Firefly

Le remplissage génératif : en conclusion

L’utilisation de l’intelligence artificielle dans le contexte de la photographie ouvre de nouvelles perspectives passionnantes tout en simplifiant certaines tâches techniques parfois rebutantes. Elle doit cependant encore relever de nombreux défis techniques et pose des questions éthiques.

Utilisez-vous déjà ces nouveaux outils ? Quel est votre ressenti ?

Cet article vous a aidé ?

Recevez ma boîte à outils photo pour progresser en photo même si vous n'avez que 5 minutes par jour.

Intéressant ou surprenant.

tout dépend de ce que l’on souhaite en faire !

cela reste un outil.

Il ne sert a rien de philosopher, temps perdu.

G.

Je préfère nettement l’intelligence naturelle à l’intelligence artificielle 😉

Elle est plus rare.

Rien de plus que ce que toute personne intéressée par la photographie que puisse déjà savoir.

En ce qui concerne les autres, cet article peut faire un bon mais succinct début de réponse réflexion. Philosophiquement parlant, l’IA ( I= Imbécilité ou Intelligence ?) n’est là que pour se substituer à l’inefficacité humaine. Le problème est de savoir d’où vient justement cette inefficacité : trop grande quantité et/ou complexité pour l’humain ou manque de technique (donc d’apprentissage) de celui-ci ?

Dans l’éventualité qu’il s’agisse de la seconde éventualité, cela reviendrait à dire que l’on est en présence d’un palliatif à l’ignorance (ou flemme) humaine. Peu reluisant tout de même !

Et si c’était dans le premier cas, alors il faut également mettre des limites : ce n’est pas parce qu’une chose est complexe qu’elle n’est pas réalisable…sauf si on place la discussion sur le niveau économique (prix important).

Donc l’IA, oui…un peu … et encore….

Excellent article, l’IA est là et il faudra faire avec.

Pour ma part je fais de la photo animalière je devrais dire plutôt de l’observation de la faune sauvage et si possible de la photo.

L’IA ne remplacera jamais l’émotion que j’ai à m’immerger dans le milieu naturel et observer un peu de l’intimité des animaux sauvages.

Il en est sûrement de même pour quelqu’un qui fait du paysage ou du portrait par exemple.

Des appareils trouvent maintenant l’œil des humains et animaux tout seul moi je préfère chercher le regard de mon sujet tant pis si j’ai plus de ratés.

Je pense qu’il faut avant tout aimer son sujet.

D’un autre coté j’apprécie l’aide précieuse de l’IA pour par exemple détourer le sujet ou un objet enlever un élément gênant (du moment qu’on le dit pas de problème pour moi) le traitement du bruit numérique également.

Maintenant je suis un amateur mon gagne pain ne dépend pas de la photo, pour un professionnel il en va différemment bien sûr.

Comme toujours tout dépendra de ce qu’on fait de cet outil.

Merci pour cet article qui amène à la réflexion sur le pourquoi de notre pratique

Tout dépend de l’objectif que l’on poursuit en photographie :

– avoir l’émotion de la prise de vue

– gagner du temps lors de la retouche photo. Temps qui permettra d’aller faire d’autres photos.

– avoir la plus belle image pour gagner un concours ou avoir le plus de likes possible

Personnellement, ce sont les deux premiers qui m’intéressent.

Je laisse le dernier aux narcissiques et aux « t’as vue » et aux « super, c’est bon pour le concours xyz ».

La réalisation d’une photo, c’est d’abord de traduire un ressenti lors de la prise de vue et de tenter de le faire passer. Certes l’IA y arrivera, mais l’émotion que je ressens lors de la prise de vue est bien humaine et est, et restera intraduisible par une machine.

Quant au remplissage génératif, la solution la plus rapide, et de loin, consiste à cadrer plus large.

Et je passe sur les autres exemples.

Il y a longtemps que les illustrateurs et autres travaillent à assembler des photos pour donner de nouvelles images créatives. L’IA leur permettra d’aller plus vite et plus loin.

Merci pour cet article qui fera couler beaucoup « d’encre » virtuelle..

– Article très passionnant, les futurs photos seront t’elles réelles, comment reconnaître une photo réalisée par un photographe ou une photo réalisée par l’intelligence artificielles.

et article ouvre un abime de réflexions.

Merci

Bonjour,

Article passionnant qui montre l’évolution de l’IA générative, jusqu’où ira-t-on ma bonne dame…? Le remplacement d’un « objet » par un autre n’est pas nouveau, dans Lightroom, souvent il remplace une tache du capteur à éliminer… par une autre si l’on serre trop près !

Et pour le logo Firefly, l’IA peut-elle s’en charger 🙂 ? A voir.

Merci !

J’adore l’exemple de la tache 🙂

J’ai commencé la photo avec le Kodak folding de ma mère en 1960… Mon dernier appareil est un non reflex plein format avec, dans son « menu » des dizaines de « lignes » que je n’utilise pratiquement jamais et, pour certaines, dont j’ignore ce qu’elles signifie. J’opère en M, mais c’est une façon de parler : je choisis ISO, vitesse et diaphragme et je vois dans le viseur si la combinaison des trois annonce ou pas un cliché à peu près correctement exposée. Donc, je m’en remets à l’ordinateur central, finalement, comme les pilotes d’avion depuis plus de quarante ans désormais. L’IA apporte-t-elle un « plus » à ces aides artificielles dont nous bénéficions toutes et tous depuis longtemps ? L’homo sapiens devrait (devra) savoir être le maître d’ lA car dans IA il y a le A : « artificielle »…Vous pouvez jouer sur les most tant que vous voulez, un artifice demeure un artifice. Et quand on voit quel genre d’homo sapiens aux USA vante les merveilles de l’IA, on peut sourire.

Super article, bravo, très ludique

Merci pour cet éclairage simple, concis mais néanmoins très intéressant.

Excellentes explications.

Ah si les traînées d’avions sur fond de ciel bleu pouvaient disparaître d’un prompt ! Sur mes dernières photos j’ai plus de traces blanches que de ciel bleu, quasiment impossibles à retoucher convenablement.

Bonjour Fredo, Merci pour ce retour. Concernant les trainées dans le ciel, lorsqu’elles chevauchent d’autres éléments de l’image (par exemple les branches d’un arbre) il est effectivement laborieux de les traiter au tampon. Le remplissage génératif peut également se tromper car les trainées ne seront pas considérées comme appartenant au ciel.

Très intéressant, merci

Merci !